Nota: questo articolo è una traduzione e rielaborazione di un articolo del nostro partner Piwik PRO, qui trovi la versione originale.

Perché parliamo di e-commerce analytics

Il tasso medio di abbandono del carrello per gli acquisti online supera il 70%. Questa rappresenta una sfida enorme per gli e-commerce: come si possono raggiungere efficacemente gli utenti portarli a convertire? Un elemento cruciale sono i dati raccolti da uno strumento di analisi dell'ecommerce.

Le aziende e-commerce hanno bisogno di prendere decisioni basate sui dati per comprendere meglio le azioni dei clienti e favorire la crescita e i profitti. I

Come? Raccogliendo i dati giusti, ricavandone informazioni granulari sul pubblico e usare queste informazioni per prendere delle azioni specifiche. L'e-commerce analytics consiste proprio in questo.

In questo articolo spieghiamo come sfruttare l'e-commerce analytics per creare campagne più efficaci, aumentare le vendite e rafforzare il posizionamento del vostro marchio.

Cosa significa e-commerce analytics?

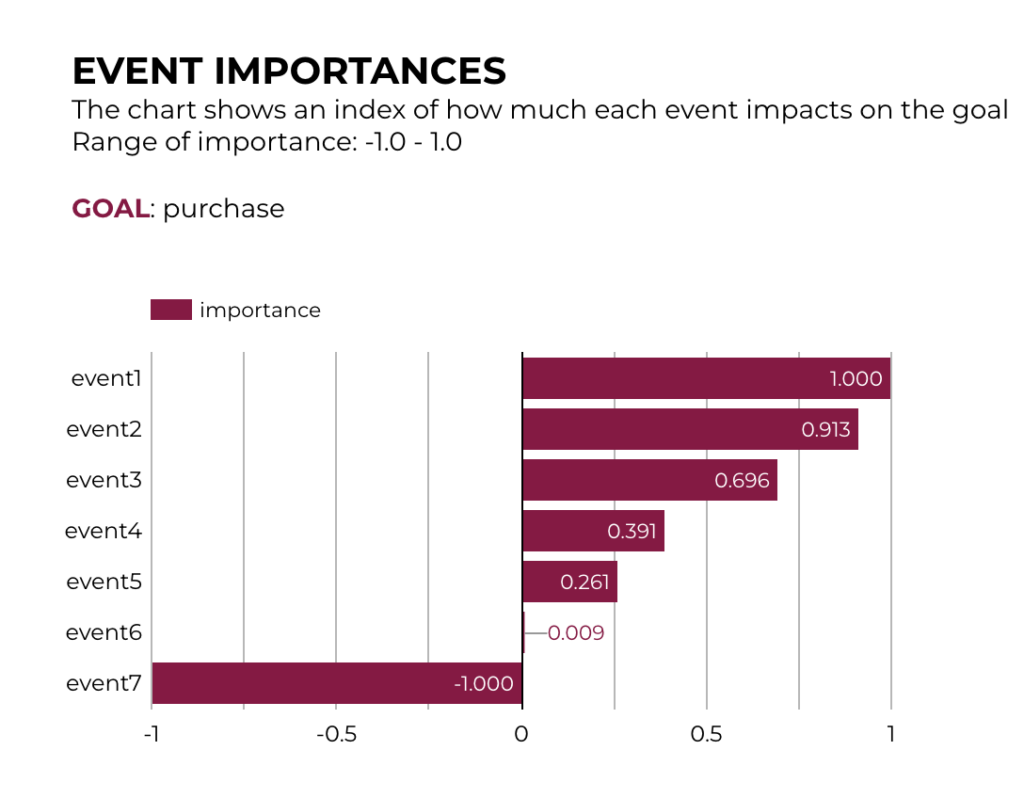

L'analisi dell'e-commerce comporta la scoperta, l'interpretazione e la comunicazione di modelli di dati relativi al business online. Questo processo comporta il monitoraggio di una serie di metriche relative al percorso del cliente dalla A alla Z, tra cui la scoperta, l'acquisizione, la conversione, la fidelizzazione e l'advocacy.

Analizzando i dati provenienti da più fonti, le aziende di e-commerce possono ottenere informazioni sull'andamento del proprio negozio, identificare le aree di miglioramento e prendere decisioni basate sui dati per ottimizzare le vendite online e gli sforzi di marketing.

Quali tipi di dati si possono tracciare con l'e-commerce analytics?

È possibile utilizzare l'e-commerce analytics per tracciare una serie di informazioni sugli utenti:

Audience

Raccogliere informazioni per ottenere approfondimenti sui dati demografici del pubblico, come ad esempio:

- Sesso

- Età

- Posizione geografica

- Lingue parlate

- Dispositivo

Ottenere una visione delle customer persona sulla base dei dati consente di determinare i punti dolenti da affrontare, apportando miglioramenti alle iniziative di marketing.

Acquisition

I dati sull'audience vi informano su come i visitatori vengono a conoscenza della vostra attività e su come finiscono sul vostro sito web.

Ecco alcune metriche da tenere a mente in relazione all'acquisizione dei clienti:

- Click-through Rate (CTR)

- Costo per lead (CPL)

- Costo per acquisizione (CPA)

Utilizzando i dati di acquisizione, potrete scoprire quali sono i canali di marketing che generano più traffico e che portano al maggior numero di conversioni e vendite. Potete anche vedere quali sono i canali di marketing online più efficaci e quali quelli che non funzionano. Questi dati sono fondamentali per capire dove concentrare le risorse.

Behavior

Un altro tipo di dati da analizzare è il comportamento dei clienti dopo che sono arrivati sul vostro sito e-commerce. Gli approfondimenti sul comportamento dei clienti vi aiutano a capire i percorsi che i visitatori compiono di solito quando interagiscono con il vostro negozio online e a capire quanto siano in linea con le azioni che volete che completino.

Ecco alcune domande che potete porvi per avere un'idea del comportamento dei vostri clienti:

- Quali prodotti acquistano i clienti alla fine della loro sessione?

- Quanti visitatori abbandonano subito il vostro sito web?

- Quali sono le pagine che gli utenti visitano per prime dopo essere arrivati sul vostro sito?

- Quali sono i contenuti di marketing più visitati dagli utenti?

- Quali prodotti ricevono molto traffico ma poche vendite?

- Quanto tempo trascorrono in media gli utenti sul vostro sito?

- L'analisi del comportamento vi aiuta a scoprire quali aspetti del vostro negozio potete migliorare per aumentare i tassi di coinvolgimento e i livelli di conversione.

Se i visitatori abbandonano rapidamente le pagine del vostro sito e non interagiscono con esse, dovete indagare sulle possibili cause, ad esempio:

- Le pagine si caricano lentamente.

- Il sito web o i prodotti non soddisfano le aspettative del pubblico.

- Il negozio online è difficile da navigare o la sua offerta o i suoi contenuti sono confusi.

Conversions

Di seguito alcune metriche che danno un'idea delle vendite, del loro valore e di quali campagne di conversione devono essere migliorate:

- Tasso di conversione delle vendite

- Valore medio dell'ordine (AOV)

- Tasso di abbandono del carrello

- Fatturato

- Costo per acquisizione

- Ritorno sulla spesa pubblicitaria

Quando iniziate a scavare più a fondo nei dati che avete a disposizione, potrete scoprire:

- Quanto tempo impiega un utente tipico a convertirsi in un cliente pagante?

- Con quale frequenza i clienti tendono a convertirsi?

- Di quante visite hanno bisogno i clienti prima di effettuare il primo acquisto?

- I clienti effettuano acquisti ripetuti?

- Quanti clienti abbandonano il carrello invece di convertire?

Rispondere a queste informazioni vi aiuterà a determinare come modificare la vostra comunicazione di marketing per coinvolgere efficacemente i clienti esistenti e potenziali.

Privacy compliance ed e-commerce analytics

La salvaguardia dei dati dei clienti e il rispetto della loro privacy sono diventati un nuovo standard. L'enfasi sulla privacy e sulla sicurezza deriva dal numero crescente di normative sulla privacy dei dati, dalla maggiore consapevolezza dei consumatori e dalla crescente applicazione delle normative.

Normative sulla privacy nell'e-commerce

Il punto focale delle normative sulla privacy dei dati è il trattamento dei dati personali e la protezione della privacy dei consumatori online. Poiché il vostro e-commerce tratti regolarmente tutti i tipi di dati personali, è necessario comprendere e rispettare le leggi applicabili. Verificate quali sono le normative applicabili alla vostra attività, sia che si tratti di leggi che riguardano paesi specifici, come il TTDSG tedesco o le linee guida del CNIL francese, sia che si tratti di leggi con un'applicazione più ampia, come il GDPR.

Cambiamenti tecnologici orientati alla privacy

Il panorama dell'e-commerce è influenzato anche da cambiamenti tecnologici. L'evento più rilevante è la fine delle campagne pubblicitarie di retargeting come le conosciamo, a causa della deprecazione dei cookie di terze parti.

Per adeguarsi ai cambiamenti tecnologici che riguardano la privacy, è bene adottare le seguenti misure:

- Scegliere fornitori di tecnologia attenti alla privacy che costruiscono i loro strumenti secondo i principi della privacy by design e della privacy by default.

- Assicuratevi che gli strumenti che utilizzate offrano funzioni che vi consentano di rispettare le scelte dei visitatori o di anonimizzare i dati.

- Privilegiate le fonti di dati di prima parte, ovvero raccogliete i dati utilizzando le vostre fonti.

Best practice per e-commerce analytics

Decidete quali sono le vostre esigenze e i vostri obiettivi

L'obiettivo principale del team di marketing deve essere collegato agli obiettivi aziendali generali. Stabilire gli obiettivi prima di immergersi nelle analisi è il modo migliore per garantire che il team lavori per un obiettivo comune. Inoltre, aumenta le probabilità di raggiungere i Key Performance Indicator (KPI).

Tracciare i dati dei clienti attraverso diversi punti di contatto

Raccogliete tutti i dati di marketing sparsi su piattaforme e canali e standardizzateli per assicurarvi che siano aggiornati e coerenti. Questo rappresenta un'opportunità per le aziende di fornire ai clienti un viaggio senza soluzione di continuità attraverso diversi touchpoint o canali di marketing, tra cui mobile, web e social media. Man mano che il vostro stack di marketing si espande, la presenza di tutti i dati in un unico luogo vi consentirà di avere un quadro chiaro del comportamento dei vostri utenti per individuare le aree di miglioramento.

Implementare la giusta data stack

Una data stack integrata contribuirà a migliorare l'accuratezza dei dati e a migliorare il processo decisionale. Assicuratevi che la vostra configurazione soddisfi le esigenze dei vostri team, non richieda troppe risorse e vi aiuti a raggiungere i vostri obiettivi di marketing e di business.

Unisci i puntini tra i tuoi clienti e i dati

Gli strumenti di marketing spesso forniscono una quantità eccessiva di dati: non cadete nella trappola di raccogliere semplicemente quanti più dati possibile. È necessario avere uno scopo per ogni dato raccolto. I dati diventano preziosi quando si mettono in relazione i numeri con i clienti. Se si considerano i dati in modo isolato, si possono commettere errori, perché non si riesce a vedere il quadro generale.

Adattare i dati alla stagionalità e ad altre tendenze

L'analisi analitica consente di scoprire le tendenze, identificare gli schemi e scoprire la stagionalità. In questo modo è possibile comprendere meglio le prestazioni attuali dell'azienda e il suo potenziale futuro. Questo, a sua volta, vi permette di fare previsioni più accurate che possono informare le vostre azioni future.

Monitorare le prestazioni dei prodotti nel tempo

Il monitoraggio delle prestazioni della categoria di prodotti e dei singoli prodotti nel corso del tempo vi consentirà di scoprire quali sono i maggiori fattori di guadagno e su quali dovreste investire. È un ottimo punto di partenza se volete scoprire quali prodotti stanno dando buoni risultati e quali invece non stanno andando bene come previsto.

Come usare l'ecommerce analytics a beneficio del business

Valutare le tendenze e i pattern di dati in modo da poter fare previsioni accurate.

Le moderne piattaforme di analisi dei dati di e-commerce trattano i dati come un sistema interconnesso, consentendovi di scoprire tendenze e modelli. Le previsioni sono utili per qualsiasi cosa, dalle assunzioni agli obiettivi di vendita, fino a garantire che i prodotti giusti siano accessibili al momento giusto per soddisfare le aspettative dei clienti.

Capire i clienti.

I report sulla crescita, il coinvolgimento e il fatturato aiutano a capire il comportamento dei clienti. Questa conoscenza può informare su quali formati, contenuti e canali attraggono e risuonano con i vostri target demografici. È possibile utilizzare l'analisi dei dati dell'e-commerce per posizionare in modo ottimale i prodotti e supportare il percorso di acquisto dei clienti.

Ottimizzare i prezzi e l'inventario.

Il prezzo dei prodotti è la leva più potente per migliorare la redditività. Con l'analisi dell'e-commerce, potrete avere un quadro granulare di ciò che determina i prezzi per ogni segmento di consumatori. È possibile utilizzare questa conoscenza per scoprire i migliori punti di prezzo a livello di prodotto, piuttosto che di categoria, per ottimizzare i ricavi.

Misurare l'efficacia delle campagne di marketing e di vendita.

L'analisi dei dati può aiutare le aziende di e-commerce a misurare il successo delle loro campagne di marketing, a migliorare il processo decisionale, a ottenere una maggiore trazione omnichannel e a informare i programmi di marketing olistici. È possibile tenere sotto controllo tutte le campagne, dagli annunci sui social alle e-mail al SEO, e vedere le statistiche in tempo reale, in modo da poter reagire rapidamente e utilizzare i dati di marketing per la crescita dell'e-commerce.

L'attivazione efficace dei dati per un'azienda di e-commerce richiede gli strumenti giusti. Le Customer Data Platform (CDP) consentono di integrare i dati provenienti da CRM, software di posta elettronica, strumenti di automazione del marketing, analisi, registrazioni offline, ecc.

Una CDP consente di visualizzare i dati dettagliati dei clienti e di creare segmenti che corrispondono al pubblico target. Per individuare i segmenti migliori, analizzate i comportamenti degli utenti, la cronologia degli acquisti, gli interessi, i dati demografici e così via.

Esempi di attivazione dei dati sono:

- Retargeting degli utenti con annunci a cui è più probabile che rispondano.

- Eseguire un test A/B per vedere quale messaggio, pagina o versione dell'annuncio converte meglio.

- Mostrare agli utenti contenuti personalizzati in base ai contenuti che hanno visualizzato.

- Fornire raccomandazioni sui prodotti in base ai prodotti o ai servizi per i quali gli utenti hanno mostrato interesse.

- Creare percorsi di acquisto unici per diversi tipi di clienti.

- Inviare campagne e-mail personalizzate in base alla cronologia degli acquisti degli utenti.

- Integrare i dati web o dell'app sull'attività degli utenti (pagine visitate, ultima attività, obiettivi raggiunti) con un CRM per scoprire e prevenire il potenziale abbandono.

Poiché una CDP è costituita da dati di prima parte, è possibile controllare la provenienza e il trattamento dei dati, permettendovi di allinearvi meglio alle normative sulla privacy.

Conclusioni

In conclusione, l'e-commerce analytics rappresenta un elemento cruciale per il successo delle aziende online, consentendo loro di prendere decisioni informate basate sui dati per migliorare le vendite, la fidelizzazione dei clienti e l'efficacia delle campagne di marketing. Attraverso l'analisi dei dati demografici, di acquisizione, comportamentali e di conversione, le imprese possono comprendere meglio il proprio pubblico, ottimizzare i processi e adattarsi alle tendenze di mercato.

Digital Pills è impegnata nel fornire approfondimenti e soluzioni innovative per l'e-commerce analytics. Come partner di Piwik PRO siamo focalizzati sull'adozione di best practices per garantire la privacy dei dati dei clienti in conformità con le normative in evoluzione.

Se desideri saperne di più su come sfruttare al meglio l'e-commerce analytics per far crescere il tuo business, contattaci cliccando qui. Digital Pills è disponibile per offrire consulenze personalizzate, rispondere alle tue domande e fornirti informazioni dettagliate sui nostri servizi e prodotti. Raggiungi nuovi livelli di successo nell'e-commerce attraverso decisioni informate e strategie mirate.